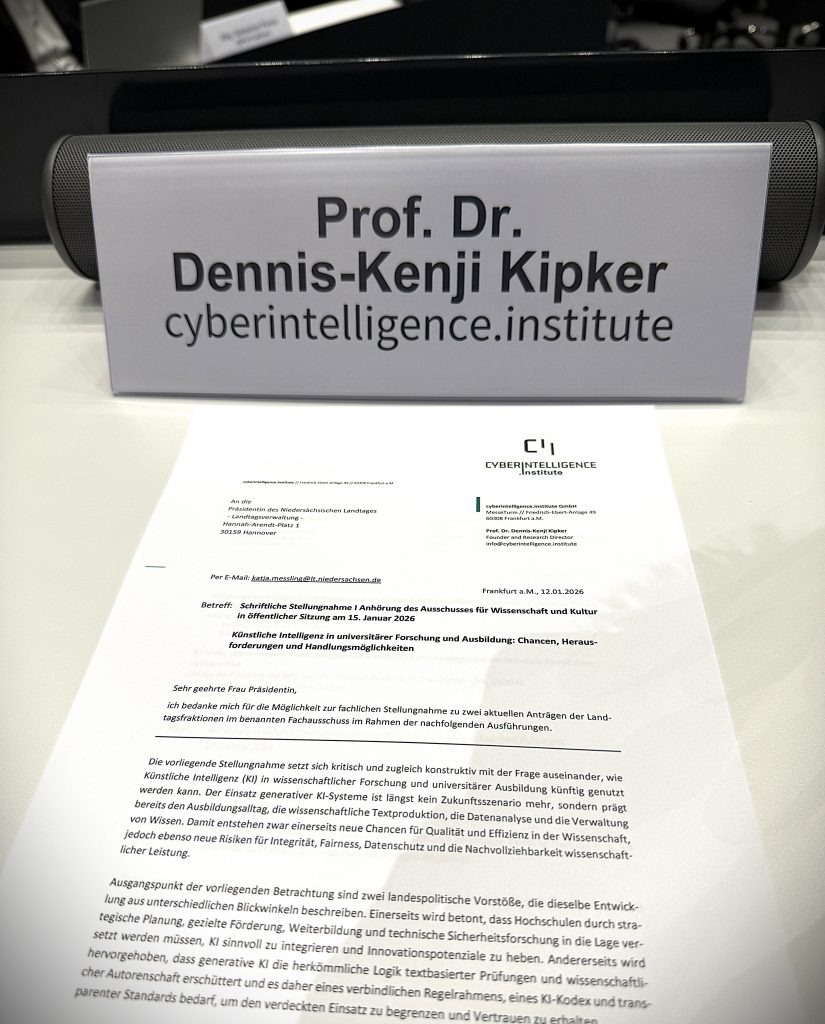

4 Stunden #KI-Anhörung im #Landtag von #Niedersachsen: Die in Hannover geladenen Sachverständigen waren sich weitestgehend einig – es braucht klare Vorgaben zum Einsatz von KI an den Hochschulen und Universitäten – und zwar jetzt. Wie ein solches strategisches #AI-Rahmenwerk in der #Wissenschaft aussehen könnte, habe ich in meiner schriftlichen Stellungnahme für das cyberintelligence institute entwickelt:

Erstens müssen Hochschulen und Länder einen kohärenten Rahmen schaffen, der Leitlinien, Kodizes, Prüfungsregeln und gute wissenschaftliche Praxis in der KI-Nutzung miteinander verbindet. Dieser Rahmen muss verständlich sein, praxistaugliche Beispiele enthalten und Verfahren vorsehen, wie er aktualisiert wird. Er sollte nicht nur Verbote aussprechen, sondern zulässige Nutzungsszenarien definieren, weil gerade die konstruktive Nutzung gezielten Kompetenzaufbau ermöglicht.

Zweitens braucht es faire und sichere Zugänge. Wenn KI im Studium relevant ist, darf sie nicht vom privaten Budget der Studierenden abhängen. Gleichzeitig müssen Datenschutz, IT-Sicherheit und Rechtskonformität gewährleistet sein. Institutionelle Angebote, möglichst mit auditierbaren Datenflüssen und klaren Nutzungsbedingungen, sind dafür zentral. Wo externe Anbieter genutzt werden, sollten Kriterien gelten, die Rechtsdurchsetzung erleichtern und Abhängigkeiten begrenzen sowie Datensouveränität wahren. Eine gestufte Strategie, die sensible Bereiche besonders schützt, ist realistischer als eine Einheitslösung.

Drittens müssen Prüfungsformate systematisch weiterentwickelt werden. Das Ziel dabei ist, Kompetenzen so zu prüfen, dass eigenständiges Denken sichtbar bleibt. Prozessorientierung, Reflexion und passende mündliche Prüfungselemente können hierbei helfen, ohne Inklusion und Machbarkeit zu opfern.

Viertens ist Qualifizierung der Schlüssel: Lehrende brauchen didaktische und rechtliche Sicherheit, Studierende brauchen KI-Literacy und Verifikationskompetenz.

Fünftens sollte Forschung zu Sicherheit, Daten- und Geschäftsgeheimnisschutz, Transparenz und alternativen, schlankeren KI-Modellen gezielt gefördert werden, damit Hochschulen nicht nur Nutzerinnen, sondern Mitgestalterinnen und Teilhaber vertrauenswürdiger KI werden.

Sechstens braucht es eine Kultur, die Transparenz und Redlichkeit stärkt. KI wird nur dann zu einem nachhaltigen Bestandteil von Forschung und Lehre, wenn sie nicht als Mittel zur Leistungsabkürzung, sondern als Werkzeug zur Vertiefung verstanden wird. Diese Kultur entsteht durch klare Erwartungen, durch Vorbilder in der Wissenschaft, durch offene Diskussion über Grenzen und durch Strukturen, die verantwortliches Handeln erleichtern. Wer jetzt in Regeln, Infrastruktur, Qualifizierung und KI-Sicherheitsforschung investiert, schafft die Grundlage dafür, dass KI nicht das Vertrauen in Wissenschaft und Ausbildung schwächt, sondern ihre Leistungsfähigkeit perspektivisch verantwortungsvoll erweitert. Die vollständige Stellungnahme mit allen inhaltlichen Impulsen gibt es zum Download auf der CII-Website: https://cyberintelligence.institute/news-media/cii-sechs-punkte-plan-zu-ki-in-der-forschung-i-anhoerung-im-land